-

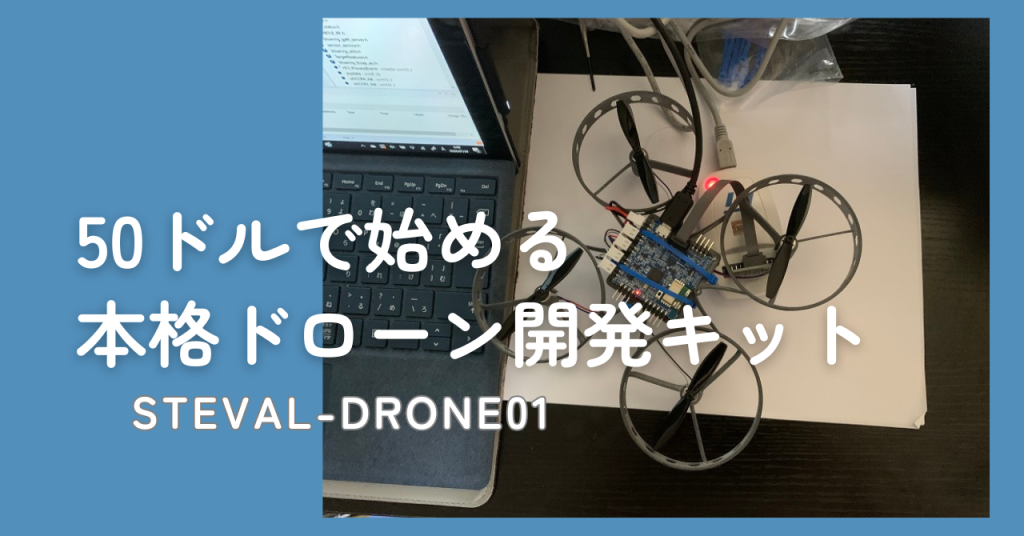

プログラムで制御を学べる!低価格ドローンキット(ST-DRONE)を試してみた

-

【2024】OpenCV×ラズパイで実現!顔認証&顔識別によって漫画キャラの反応を変える

-

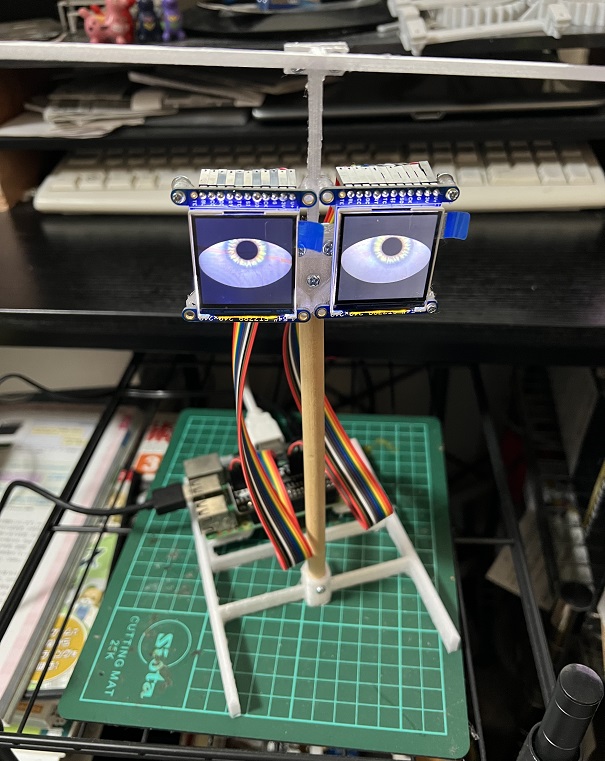

3Dプリンターを使って、petoi bittleにアニメキャラ「魔法少女まどかのキュウべえ」の外形を作って見た。

-

4足歩行ロボット Petoi BITTLE を購入!ラジコンのような操作感が楽しい

-

透過型ディスプレイを自作してプラモの背景を作る!

-

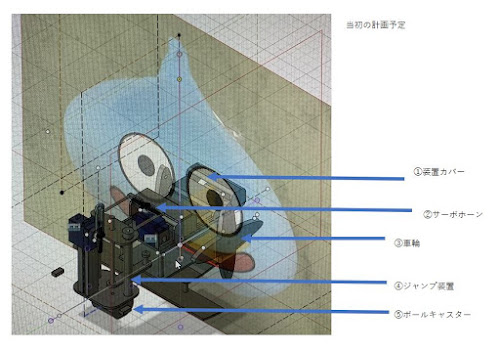

ガンプラ(ケンプファーアメイジング)のカタパルトを作成して発進シーンを再現する

-

あの恐怖の人面蜘蛛を再現!鬼滅の刃の世界をラジコンで具現化

-

爆走!スライムラジコン製作記3(自作ラジコン) 製作編

-

爆走!スライムラジコン製作記2(自作ラジコン) 3Dプリント編